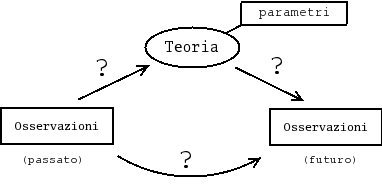

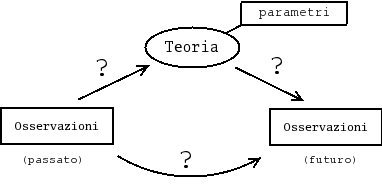

Il lavoro di ricerca degli scienziati può essere schematizzato, in modo molto generale, secondo il seguente diagramma.

Partiamo dal link che lega direttamente le osservazioni passate (OP) alle osservazioni future (OF). Esso è associato al processo mentale di induzione: da un numero limitato di casi osservati, tentiamo di immaginare cosa potrà succedere in uno qualsiasi degli infiniti casi analoghi che non sono ancora accaduti. È sufficiente esprimere in questi termini la questione per comprendere immediatamente quali siano le difficoltà e le incertezze in gioco. Si tratta sostanzialmente del ben noto problema dell'induzione di Hume. Inoltre ci si rende conto che l'uso del solo link OP-OF sarebbe, oltre che incerto, decisamente inefficiente, in quanto richiederebbe un numero infinito di regole.

L'introduzione di una teoria (T), che funge da tramite fra il passato e il futuro attraverso il collegamento OP-T-OF, semplifica il meccanismo di previsione in quanto riduce il numero di regole, che diventano di conseguenza più generali. Essa non risolve invece il problema di come costruire le regole a partire dalle osservazioni. Come facciamo a formulare una teoria? Certamente non sono i puri dati empirici ad imporla. Per liquidare la questione con una battuta, tanti hanno visto mele cadere e la luna girare intorno alla Terra, ma bisognava attendere Newton per capire che si trattava sostanzialmente dello stesso fenomeno. Se c'è un aspetto della scienza che è difficilmente modellizzabile è la formazione delle idee scientifiche. Per dirla con Einstein, "I concetti della fisica sono libere creazioni dello spirito umano e non sono, nonostante le apparenze, determinati unicamente dal mondo esterno", con buona pace per Newton il quale asseriva di 'dedurre' le leggi fisiche dalle sole osservazioni sperimentali ("hypotheses non fingo"!). Quindi saltiamo a pié pari la questione, assumendo che ci sia qualcuno abbastanza creativo da avere un'intuizione sulla quale costruire una teoria (o un qualche modello - sorvoliamo sulla classificazione di cosa sia degno del nome teoria e di cosa sia più modestamente un modello) o di modificarne una esistente. Le sezioni teoriche delle riviste scientifiche e degli archivi di preprint elettronici (si consultino ad esempio le novità di hep-ph o hep-th) mostrano che la fantasia non manca.

Limitiamo quindi la questione a come selezionare le varie teorie alla luce dei dati sperimentali. Ma prima è importante capire la ragione delle incertenze nei collegamenti OP-T e T-OF. Essenzialmente il problema risiede nel fatto che, contrariamente all'approccio ipotetico-deduttivo classico, bisogna ammettere che sia lo stesso collegamento T-OF ad essere intrinsecamente incerto. Innanzitutto bisogna notare che le teorie non collegano le osservazioni sperimentali esattamente come le percepiamo con i nostri sensi, eventualmente mediati da strumenti più o meno sofisticati. Esse operano invece su entità astratte, quali massa e forza, le quali ad esempio non vanno confuse con l'indicazione dell'ago di una bilancia o di una molla tarata. Ne risulta che, anche assumendo di essere sicuri della teoria e dei valori numerici dei suoi parametri, non siamo sicuri di cosa osserveremo. Imputiamo questa incertezza ai cosiddetti errori di misura. Altre volte imputiamo l'incertezza a tutte le condizioni iniziali e le condizioni al contorno non perfettamente note (esemplare è il caso della meccanica statistica classica). Infine, altre volte riteniemo che sia la stessa teoria a fornire previsioni intrinsecamente incerte, come succede nel caso della meccanica quantistica. In tutti i casi possiamo imputare la nostra incertezza alla relazione non deterministica fra le cause apparenti (una ben precisa teoria e con i valori esatti dei suoi parametri) e gli effetti che ne derivano (le osservazioni), secondo lo schema seguente:

Dall'inizio dello scorso secolo c'è stata finalmente una decisa presa di coscienza sul fatto che l'induzionismo naïve, del tipo di quello professato da Newton, sia logicamente insostenibile e che, di conseguenza, le osservazioni sperimentali non ci obbligano ad abbracciare una sola teoria possibile (quella Vera). Fra le varie soluzioni epistemologiche al problema di come basare la Scienza sui dati sperimentali (senza però cadere nei trabocchetti logici dell'induzionismo) e separarla così dalla non-scienza, quella che ha avuto più risonanza (non dico successo per i motivi che vedremo) è il falsificazionismo, legato al nome di Popper: ogni teoria deve essere falsificabile, nel senso che devono essere concepibili esperimenti nei quali essa può eventualmente fallire e che ci costringono così a ripudiarla. In realtà anche questo approccio non è esente da critiche, la più severa delle quali è, a mio giudizio, che esso non descrive il modo secondo cui la scienza avanza (esistono altre critiche più tecniche sulle quali non entro). Cosa facciamo di tutte le (virtualmente infinite) teorie non falsificate? Le teniamo in una specie di Limbo? Come programmiamo la ricerca scientifica? Ci mettiamo a falsificare tutte le teorie formulate e poi andiamo avanti? La pratica scientifica mostra come gli esperimenti vengano pianificati per testare le teorie più credibili, mentre il concetto di credibilità (o plausibilità) è assolutamente estraneo al falsificazionismo. Inoltre i teorici sviluppano delle teorie usando dei loro criteri di plausibilità, incomprensibili agli estranei (spesso anche ai loro colleghi sperimentali), e non stanno certo ad aspettare il vaglio della falsificazione. Come scrisse Einstein "Se volete scoprire qualcosa sui metodi che usano i fisici teorici, vi consiglio di attenervi ad un principio: non date retta alle loro parole, ma osservate attentamente le loro azioni".

La situazione sembra senza speranza e può portare all'estremismo di negare l'esistenza di un metodo scientifico e la scienza stessa diventa un punto di vista alla stessa stregua di qualsiasi altro (vedi Feyerabend).

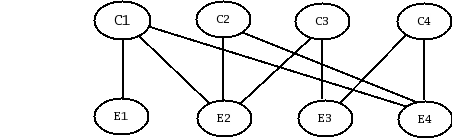

Secondo chi scrive e una comunità ancora esigua di di matematici, statistici, filosofi e scienziati di varie discipline, la soluzione consiste nella cosiddetta induzione probabilista, nota anche come inferenza bayesiana, basata sulla probabilità soggettiva, ovvero sul grado di fiducia che un evento possa essere accadere o che una ipotesi possa essere vera. Questo concetto di probabilità corrisponde a quello intuitivo. Esso ha un ruolo cruciale nell'inferenza probabilistica in quanto ci permette non solo di classificare secondo una scala di credibilità le diverse osservazioni possibili, avendo assunto per certe delle ipotesi, ma anche di classificare con una analoga scala le possibili ipotesi alla luce delle osservazioni sperimentali. Con riferimento al diagramma cause-effetti, possiamo così parlare sia di P(Ei | Cj) , ovvero della probabilità dell'effetto Ei data la causa Cj , che di P(Cj | Ei), ovvero della probabilità della causa Cj dato l'effetto Ei.

Questo approccio, apparentemente nuovo, si rifà alle idee dei padri fondatori della teoria della probabilità, come ad esempio Bayes, Laplace e Gauss. Negli ultimi decenni è tornato in auge grazie sia al lavoro, teorico che ha chiarito alcuni aspetti controversi (decisivo il contributo del nostro de Finetti), che ai progressi sul piano computazionale. Tale approccio non à soltanto in grado di proporre un modo di imparare dai dati sperimentali che riesca a superare induzionismo e falsificazionismo naïve, ma riesce anche a rendere conto di alcuni processi mentali, eseguiti seppur a livello intuitivo e qualitativo, degli scienziati per classificare le teorie scientifiche soppesando sia i pregiudizi teorici che il supporto sperimentale. Lo strumento chiave dell'induzione probabilistica è il teorema di Bayes, che, senza entrare nel merito di come le ipotesi vengono formulate, ci insegna come aggiornare le probabilità delle ipotesi secondo il seguente semplice schema:

' sta per 'proporzionale a' e

la condizione I indica lo stato di informazione sotto cui

l'inferenza è effettuata.

Si capisce subito che se una causa

non può produrre un effetto, ovvero se la probabilità

di quell'effetto data quella causa è nulla, allora

l'osservazione di tale effetto falsifica l'ipotesi.

Il falsificazionismo viene quindi recuperato

come caso limite. Ma adesso riusciamo anche a tener

conto del fatto che ipotesi non falsificate possono

descrivere più o meno bene i dati (secondo la probabilità

che le diverse ipotesi producano quei dati)

e anche del fatto che diverse ipotesi siano a priori

più o meno credibili.

' sta per 'proporzionale a' e

la condizione I indica lo stato di informazione sotto cui

l'inferenza è effettuata.

Si capisce subito che se una causa

non può produrre un effetto, ovvero se la probabilità

di quell'effetto data quella causa è nulla, allora

l'osservazione di tale effetto falsifica l'ipotesi.

Il falsificazionismo viene quindi recuperato

come caso limite. Ma adesso riusciamo anche a tener

conto del fatto che ipotesi non falsificate possono

descrivere più o meno bene i dati (secondo la probabilità

che le diverse ipotesi producano quei dati)

e anche del fatto che diverse ipotesi siano a priori

più o meno credibili.

Un ultimo punto da chiarire è come si possa effettivamente, a partire dalla probabilità soggettiva e da questo schema di aggiornamento arrivare ad una costruzione solida, 'oggettiva', della scienza. Innanzitutto ci vuole poco a capire come, alla luce di quanto detto precedentemente, l'ideale di l'oggettività non sia che un pio desiderio. Al più è lecito parlare di intersoggettività, la quale può manifestarsi a diversi livelli: se una comunità di persone razionali dispone delle stesse, solide informazioni sperimentali e della stessa scelta di modelli si può dimostrare facilmente come il teorema di Bayes produca una convergenza di opinioni a posteriori, anche se esse erano inizialmente divergenti, purchè ciascuno sia disposto a mettere in dubbio la sua convinzione iniziale. Quindi, dopo secoli di sperimentazione scientifica e di speculazione teorica, abbiamo una 'rete di credenze' scientifiche molto solida, tale che è difficile non credere ad un elemento senza metterne in discussione tanti altri. Intorno a questo nocciolo duro, che corrisponde alle teorie consolidate e condivise, ci sono aree più sfumate in cui le opinioni degli scienziati possono essere contrastanti e che consistono alle aree di ricerca attuale.

Per saperne di più: